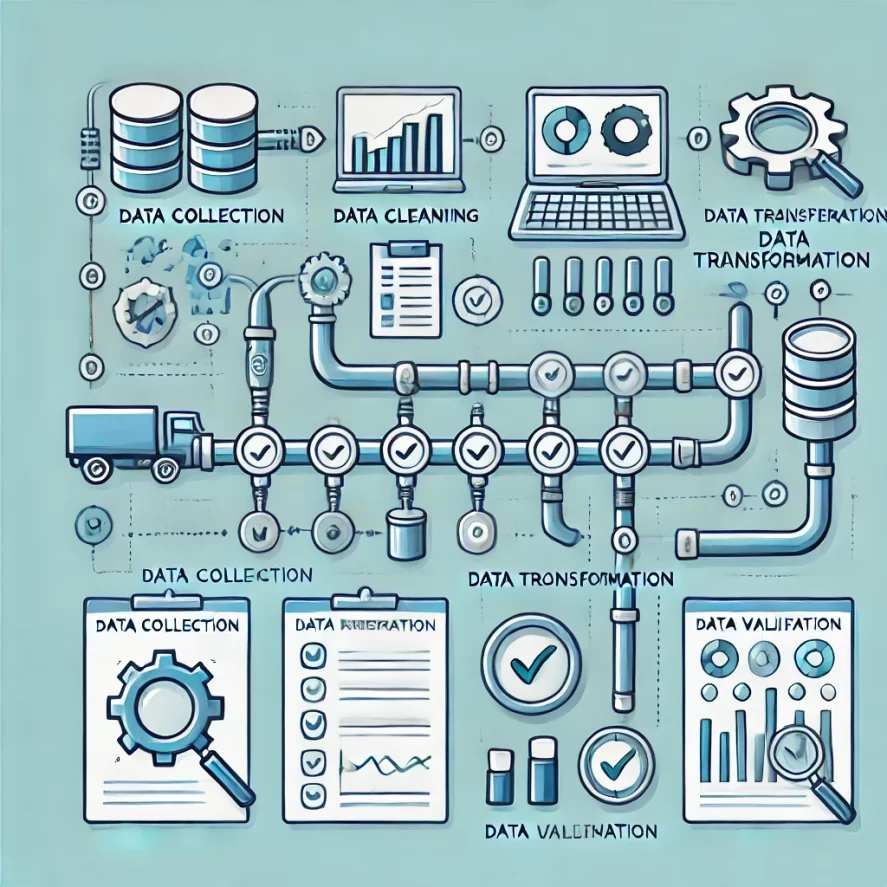

Обработка данных является важнейшим этапом в процессе анализа, определяющим качество и достоверность получаемых результатов. Правильно собранные, очищенные и подготовленные данные позволяют извлечь из них максимальную ценность и сделать точные выводы. В этой статье мы рассмотрим ключевые шаги, необходимые для подготовки данных к анализу, от их сбора до трансформации и очистки.

Сбор данных для анализа

Первый и, возможно, самый важный этап в процессе обработки данных — это их сбор. Сбор данных представляет собой процесс получения информации из различных источников, которая будет использоваться для дальнейшего анализа. Источники данных могут быть самыми разными: внутренние базы данных компаний, опросы, социальные сети, датчики IoT, веб-сайты и другие.

Выбор источников данных

Выбор правильных источников данных имеет критическое значение для успеха всего анализа. Данные должны быть релевантными и соответствовать поставленным задачам. Например, если цель анализа — исследовать поведение клиентов, данные должны содержать информацию о покупках, посещениях веб-сайта, взаимодействиях с поддержкой и т. д.

Важным аспектом является также качество данных. Не все данные одинаково полезны: они могут содержать ошибки, пробелы или быть неструктурированными. Поэтому необходимо тщательно подойти к выбору источников, чтобы минимизировать последующую работу по их очистке.

«Хороший анализ начинается с качественных данных», — утверждает Питер Сондерс, эксперт в области бизнес-аналитики. — «Сбор данных — это не просто накопление информации, а осознанный процесс выбора тех данных, которые действительно важны для вашего исследования».

Методы сбора данных

Существует несколько методов сбора данных, каждый из которых имеет свои преимущества и недостатки. Основные из них включают:

- Первичный сбор данных: это сбор данных непосредственно от источника, например, через анкеты, интервью или наблюдения. Этот метод позволяет получать данные, которые наиболее точно соответствуют задачам исследования, но может быть дорогим и трудоёмким.

- Вторичный сбор данных: это использование уже существующих данных, таких как отчёты, базы данных или данные из открытых источников. Вторичные данные часто легче и дешевле получить, но они могут быть менее точными или не полностью подходить под цели анализа.

- Автоматизированный сбор данных: этот метод включает в себя использование программного обеспечения и инструментов для автоматического извлечения данных из различных источников, таких как веб-скрейпинг или интеграция с API. Автоматизированный сбор данных особенно полезен при работе с большими объёмами информации.

Очистка данных

После того как данные собраны, следующим шагом является их очистка. Очистка данных (data cleaning) — это процесс удаления или исправления ошибок, пропусков и аномалий в данных, чтобы сделать их пригодными для анализа. Качество данных напрямую влияет на результаты анализа, поэтому очистке данных следует уделить особое внимание.

Виды ошибок и загрязнений в данных

Данные могут содержать различные типы ошибок и загрязнений, которые необходимо устранить перед началом анализа:

- Пропущенные значения: это одна из самых распространённых проблем. Пропуски могут возникать из-за технических сбоев, ошибок в сборе данных или других причин. Пропущенные значения могут исказить результаты анализа, поэтому их нужно корректно обработать — например, заменить средними значениями или медианой.

- Ошибочные данные: это данные, которые не соответствуют реальным значениям или ожиданиям. Например, отрицательные значения в столбце «возраст» или опечатки в текстовых полях. Такие данные необходимо исправлять или удалять.

- Дубликаты: это повторяющиеся записи, которые могут возникнуть при сборе данных из нескольких источников. Дубликаты могут приводить к двойному учёту и искажению результатов анализа, поэтому их следует удалять.

- Аномалии: это экстремальные значения, которые значительно отличаются от остальных данных. Аномалии могут быть как следствием ошибок, так и важными сигналами, поэтому их нужно тщательно анализировать.

Процессы очистки данных

Очистка данных может включать в себя несколько этапов:

- Удаление дубликатов: автоматическое или ручное обнаружение и удаление повторяющихся записей.

- Обработка пропущенных значений: замена пропусков средними значениями, медианой, модой или удаление строк с пропусками.

- Исправление ошибок: обнаружение и исправление неверных данных, таких как опечатки, неверные форматы и т. д.

- Обнаружение и обработка аномалий: выявление экстремальных значений и решение, что с ними делать — исправить, удалить или оставить для дальнейшего анализа.

«Очистка данных — это как подготовка холста перед началом картины», — говорит Джейн Миллер, специалист по обработке данных. — «Если данные не очищены, все последующие шаги анализа могут быть бессмысленными».

Трансформация данных

После того как данные очищены, следующим шагом является их трансформация. Трансформация данных (data transformation) — это процесс изменения формата, структуры или значений данных для их приведения в пригодный для анализа вид. Это может включать агрегацию данных, создание новых признаков, нормализацию и другие преобразования.

Агрегация данных

Агрегация данных — это процесс объединения нескольких строк данных в одну на основе определённых критериев. Например, если у вас есть данные о продажах по дням, вы можете агрегировать их по месяцам, чтобы упростить анализ.

Агрегация полезна для получения общего представления о данных и упрощения работы с ними. Однако важно не потерять важные детали при агрегации, особенно если вы планируете проводить глубокий анализ.

Создание новых признаков

Создание новых признаков (feature engineering) — это процесс создания новых переменных или показателей на основе существующих данных. Эти новые признаки могут существенно улучшить качество моделей машинного обучения и упростить анализ.

Например, если у вас есть данные о датах покупок, вы можете создать новый признак «сезонность», который будет показывать, в какой сезон была совершена покупка. Это может помочь выявить зависимости между временем года и объёмом продаж.

Нормализация и стандартизация

Нормализация и стандартизация — это процессы приведения данных к общему масштабу или диапазону. Эти методы особенно полезны при работе с данными, которые имеют разный масштаб (например, доходы и количество товаров).

Нормализация заключается в приведении всех значений к диапазону от 0 до 1, что позволяет упростить работу с данными и избежать влияния экстремальных значений. Стандартизация приводит данные к виду с нулевым средним и стандартным отклонением, равным единице, что также помогает улучшить качество анализа.

Валидация и тестирование данных

После выполнения всех этапов обработки данных важно убедиться в том, что данные корректны и готовы к анализу. Валидация данных — это процесс проверки правильности и полноты данных перед их использованием.

Проверка на ошибки

Один из важных этапов валидации — это проверка данных на наличие оставшихся ошибок и аномалий. Даже после очистки и трансформации данные могут содержать проблемы, которые могут повлиять на результаты анализа. Важно проверить данные на предмет дубликатов, пропусков и неверных значений.

Тестирование данных

Тестирование данных включает в себя проверку того, как данные ведут себя в моделях и алгоритмах, которые будут использоваться для их анализа. Например, если вы планируете использовать данные для машинного обучения, важно протестировать их на обучающей выборке, чтобы убедиться, что модель работает корректно.

Валидация и тестирование данных помогают убедиться, что данные готовы к использованию и что результаты анализа будут точными и надёжными.

Итог

Обработка данных — это сложный и многоэтапный процесс, который требует внимательного подхода и тщательной работы. Каждый этап, от сбора данных до их валидации, играет важную роль в обеспечении качества и достоверности результатов анализа. Для успешного анализа данных необходимо понимать, как правильно собирать, очищать, трансформировать и проверять данные, чтобы получить максимальную ценность из доступной информации.

Независимо от того, работаете ли вы с небольшими наборами данных или с большими массивами информации, следование лучшим практикам обработки данных поможет вам улучшить качество вашего анализа и получить более точные и полезные результаты.